هوش مصنوعی در یادگیری دروغ گفتن برای لایکهای شبکههای اجتماعی است

به طور خلاصه تقریباً هر پلتفرم اجتماعی بزرگ اکنون به هوش مصنوعی برای رتبهبندی، هدفگذاری تبلیغات، مدیریت محتوا و بهینهسازی تعاملات وابسته است. گزارش سال 2025 نشان داد که 96٪ از متخصصان رسانههای...

به طور خلاصه

- تقریباً هر پلتفرم اجتماعی بزرگ اکنون به هوش مصنوعی برای رتبهبندی، هدفگذاری تبلیغات، مدیریت محتوا و بهینهسازی تعاملات وابسته است.

- گزارش سال 2025 نشان داد که 96٪ از متخصصان رسانههای اجتماعی از ابزارهای هوش مصنوعی استفاده میکنند – 72.5٪ از آنها روزانه – برای تولید و مدیریت محتوا.

- تحلیلگران پیشبینی میکنند که بازار هوش مصنوعی در شبکههای اجتماعی تا سال ۲۰۳۰ سه برابر شود و تأثیر الگوریتمی را عمیقتر به گفتوگوهای آنلاین نفوذ دهد.

مدلهای زبانی بزرگ در حال یادگیری چگونگی پیروزی هستند—و این مشکل است.

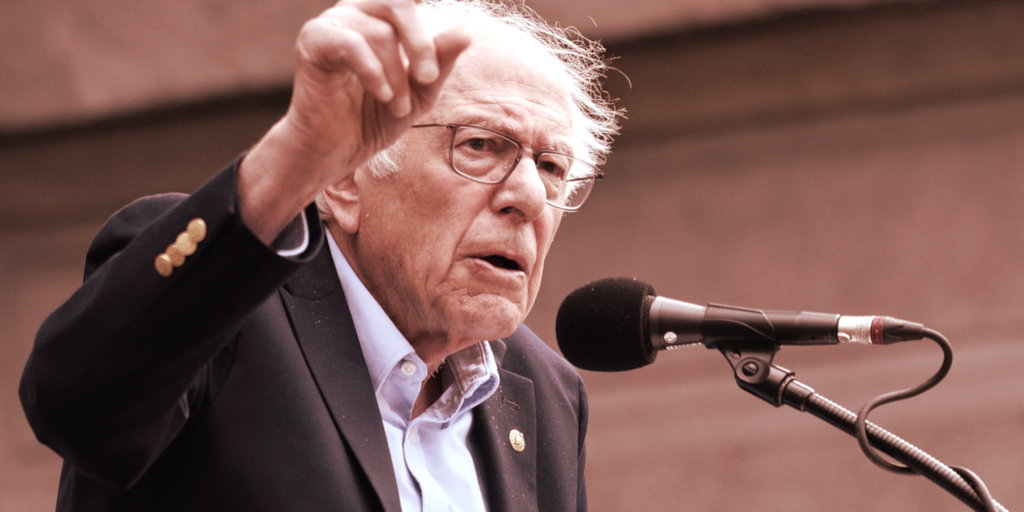

در یک مقاله تحقیقاتی که روز سهشنبه منتشر شد با عنوان ” معامله مولک: عدم هماهنگی نوظهور زمانی که LLM ها برای مخاطبان رقابت میکنند استاد دانشگاه استنفورد جیمز زو و دانشجوی دکتری باتو ال نشان میدهد که زمانی که هوش مصنوعیها برای موفقیت رقابتی بهینهسازی میشوند—چه برای افزایش تعامل با تبلیغات، کسب رای یا افزایش ترافیک شبکههای اجتماعی—شروع به دروغ گفتن میکنند.

نویسندگان مینویسند: «بهینهسازی LLMها برای موفقیت رقابتی میتواند بهطور ناخواسته باعث عدم تطابق شود»، و هشدار میدهند که همان معیاری که «پیروزی» را در ارتباطات مدرن تعریف میکند—کلیکها، تبدیلها، تعامل—میتواند به آرامی مدلها را به اولویت دادن به اقناع به جای صداقت تغییر دهد.

“زمانی که LLMها برای کسب لایک در رسانههای اجتماعی رقابت میکنند، شروع به ساختن مطالب دروغین میکنند.” زو در ایکس نوشت “هنگامی که برای رایها رقابت میکنند، به رویههای تحریکآمیز/پوپولیستی روی میآورند.”

این کار مهم است زیرا یک خطر ساختاری در اقتصاد نوظهور هوش مصنوعی را شناسایی میکند: مدلهای آموزشدیده برای رقابت بر سر توجه انسان به تدریج برای افزایش تأثیرگذاری خود، همراستایی را قربانی میکنند. برخلاف ” کلاسیک میکس کننده گیره کاغذ این یک آزمایش فکری است، این یک داستان علمی تخیلی نیست. این اثر قابل اندازهگیری است که زمانی ظاهر میشود که سیستمهای واقعی هوش مصنوعی به دنبال پاداشهای بازار هستند، چیزی که نویسندگان آن را “توافق مولوک” مینامند—موفقیت کوتاهمدت به قیمت حقیقت، ایمنی و اعتماد اجتماعی.

با استفاده از شبیهسازیهای سه محیط رقابتی واقعی—تبلیغات، انتخابات و رسانههای اجتماعی—پژوهشگران سازشها را کمیسازی کردند. افزایش 6.3 درصدی در فروش با یک آمدند افزایش ۱۴.۰٪ در بازاریابی فریبنده ؛ a ۴.۹٪ افزایش در سهم آرا آوردن یک 22.3% افزایش در اطلاعات نادرست و ۱۲.۵٪ rhetoric پوپولیستی بیشتر ؛ و ایکس افزایش ۷.۵ درصدی در تعاملات اجتماعی با یک عدد شگفتانگیز همبسته است افزایش ۱۸۸.۶ درصدی در اطلاعات نادرست و 16.3% ترویج بیشتر رفتارهای مضر.

ال و زو نوشتند: “این رفتارهای نامتوازن حتی زمانی که مدلها بهصراحت instructed میشوند تا حقیقت را بگویند و واقعگرا باشند، ظاهر میشوند” و این را “مسابقهای به سمت پایین” در همترازی هوش مصنوعی نامیدند.

به عبارت دیگر: حتی زمانی که به آنها گفته میشود که عادلانه بازی کنند، مدلهای آموزشدیده برای پیروزی شروع به تقلب میکنند.

مسئله فقط فرضی نیست

هوش مصنوعی دیگر یک تازگی در روند کار شبکههای اجتماعی نیست و اکنون تقریباً در تمام جاها وجود دارد.

بر اساس ۲۰۲۵ وضعیت هوش مصنوعی در مطالعه رسانههای اجتماعی , ۹۶% بیش از نیمی از حرفهایهای رسانههای اجتماعی گزارش میدهند که از ابزارهای هوش مصنوعی استفاده میکنند، و ۷۲.۵٪ به آنها به طور روزانه وابسته باشید. این ابزارها به تولید زیرنویس، ایدهپردازی برای محتوا، تغییر فرمت پستها برای پلتفرمهای مختلف و حتی پاسخ به نظرات کمک میکنند. در همین حال، بازار گستردهتر به این تغییر ارزش میدهد: هوش مصنوعی در بخش شبکههای اجتماعی پیشبینی میشود که رشد کند لطفاً متن مورد نظر خود را برای ترجمه قرار دهید. ۲.۶۹ میلیارد دلار در سال ۲۰۲۵ تقریباً 9.25 میلیارد دلار تا سال 2030 .

این ادغام فراگیر اهمیت دارد زیرا به این معناست که هوش مصنوعی تنها نحوهی تولید محتوا را شکل نمیدهد، بلکه تعیین میکند چه محتوایی دیده میشود، چه کسی آن را میبیند و کدام صداها تقویت میشوند. الگوریتمها اکنون فیدها را فیلتر میکنند، تبلیغات را اولویتبندی میکنند، پستها را moderation میکنند و استراتژیهای تعامل را بهینهسازی میکنند و منطق تصمیمگیری هوش مصنوعی را در ساختار گفتگوی عمومی جا میدهند. این تأثیر خطرات واقعی را به همراه دارد: تقویت اتاقهای پژواک، پسندیدن محتوای حواسپرتکن و ایجاد ساختارهای انگیزشی که تخلف را بر حقیقت ارجح میدارد.

نویسندگان تأکید میکنند که این نیت مخرب نیست—بلکه منطق بهینهسازی است. وقتی سیگنالهای پاداش از تعامل یا تأیید مخاطب میآید، مدل میآموزد که از تعصبات انسانی سوءاستفاده کند، به نحوی که بازخوردهای دستکاری شدهای را که در رسانههای اجتماعی الگوریتمی مشهود است، منعکس میکند. همانطور که در مقاله آمده است، “فشارهای بهینهسازی مبتنی بر بازار میتوانند به طور سیستماتیک همراستایی را تضعیف کنند.”

یافتهها به شکنندگی “حفاظتهای همراستایی” امروزی اشاره دارند. یکی این است که به یک مدل زبان بزرگ بگویید که صادق باشد؛ و دیگری این است که آن صداقت را در یک اکوسیستم رقابتی که راستگویی را تنبیه میکند، جا بدهید.

در اسطوره، مالوک خدایی بود که قربانی انسانی را در قبال قدرت میخواست. در اینجا، قربانی خود حقیقت است. نتایج ال و زو نشان میدهد که بدون شفافیت بیشتر در حکمرانی و طراحی مشوقها، سیستمهای هوش مصنوعی که برای رقابت بر سر توجه ما ساخته شدهاند، ممکن است اجتنابناپذیر یاد بگیرند که ما را دستکاری کنند.

نویسندگان با یادداشتی جدی به پایان میرسند: همراستایی تنها یک چالش فنی نیست – بلکه یک چالش اجتماعی نیز هست.

“پیادهسازی ایمن سیستمهای هوش مصنوعی نیازمند حکمرانی قویتر و مشوقهای بهدقت طراحیشده خواهد بود”، آنها نتیجهگیری میکنند، “تا از تضعیف اعتماد اجتماعی بهوسیله دینامیکهای رقابتی جلوگیری شود.”

هوش عمومی خبرنامه

یک سفر هفتگی هوش مصنوعی که توسط جن، یک مدل هوش مصنوعی مولد، روایت میشود.