گوگل Veo 3.1 را برای رقابت با Sora 2 از OpenAI رونمایی کرد – اما آیا این کار کرده است؟

در کوتاه مدت Veo 3.1 نسل کامل صدا، دیالوگ و تولید صدای محیط را معرفی میکند. این راهاندازی پس از افزایش سریع Sora 2 به یک میلیون دانلود در عرض پنج روز انجام میشود. گوگل ویو را به عنوان یک گزینه...

در کوتاه مدت

- Veo 3.1 نسل کامل صدا، دیالوگ و تولید صدای محیط را معرفی میکند.

- این راهاندازی پس از افزایش سریع Sora 2 به یک میلیون دانلود در عرض پنج روز انجام میشود.

- گوگل ویو را به عنوان یک گزینه حرفهای در بازار شلوغ ویدئوهای هوش مصنوعی معرفی میکند.

گوگل نسخه 3.1 ویو امروز منتشر شد نسخه بهروزرسانی شدهای از تولیدکننده ویدیوی هوش مصنوعی آن که صدا را در تمامی ویژگیها اضافه میکند و قابلیتهای ویرایش جدیدی را معرفی میکند که به creators کنترل بیشتری بر کلیپهایشان میدهد.

این اعلام در حالی صورت میگیرد که اپلیکیشن رقیب اوپنایآی، سُرا ۲، در نمودارهای فروشگاه اپلیکیشن بالا میرود و بحثهایی درباره محتوای تولید شده توسط هوش مصنوعی که به شبکههای اجتماعی سرازیر میشود، تحریک میکند.

این زمانبندی نشان میدهد که گوگل میخواهد Veo 3.1 را به عنوان گزینه حرفهای برای رویکرد فید اجتماعی ویروسی Sora 2 معرفی کند. OpenAI Sora 2 را در 30 سپتامبر با یک رابط کاربری به سبک TikTok که به اشتراکگذاری و بازنویسی اولویت میدهد، راهاندازی کرد.

این اپلیکیشن در عرض پنج روز به یک میلیون دانلود رسید و به صدر فهرست اپ استور اپل دست یافت. متا نیز رویکرد مشابهی را در پیش گرفت و نوع خاصی از رسانه اجتماعی مجازی را که با ویدیوهای هوش مصنوعی قدرتگیری میشود، ارائه کرد.

کاربران اکنون میتوانند با استفاده از “مواد به ویدیو”، ابزاری که چندین تصویر مرجع را در یک صحنه ترکیب میکند، ویدیوهایی با صدای محیط هماهنگ، دیالوگ و افکتهای فولی ایجاد کنند.

ویژگی “فریمها به ویدیو” انتقالاتی بین یک تصویر آغازین و پایانی ایجاد میکند، در حالی که “توسعه” کلیپهایی با طول حداکثر یک دقیقه ایجاد میکند که حرکت را از ثانیه پایانی یک ویدیو موجود ادامه میدهد.

ابزارهای ویرایش جدید به کاربران اجازه میدهند تا عناصر را از صحنههای تولید شده اضافه یا حذف کنند و تنظیمات نور و سایه به طور خودکار انجام میشود. این مدل ویدیوها را با وضوح ۱۰۸۰p در نسبتهای ابعادی افقی یا عمودی تولید میکند.

مدل از طریق Flow برای استفاده مصرفکننده، API Gemini برای توسعهدهندگان و Vertex AI برای مشتریان شرکتی در دسترس است. ویدیوهایی با طول حداکثر یک دقیقه میتوانند با استفاده از ویژگی “کشش” ایجاد شوند که حرکت را از آخرین ثانیه یک کلیپ موجود ادامه میدهد.

بازار تولید ویدئو با هوش مصنوعی در سال ۲۰۲۵ شلوغ شده است، با مدل Gen-4 شرکت Runway که به فیلمسازان هدفگذاری شده، Luma Labs که تولید سریع برای رسانههای اجتماعی ارائه میدهد، Adobe که Firefly Video را به Creative Cloud یکپارچه کرده و بهروزرسانیهایی از xAI، Kling، Meta و Google که به واقعگرایی، تولید صدا و پایبندی به دستورات هدفگذاری شدهاند.

اما چقدر خوب است؟ ما این مدل را آزمایش کردیم و اینها برداشتهای ما هستند.

آزمایش مدل

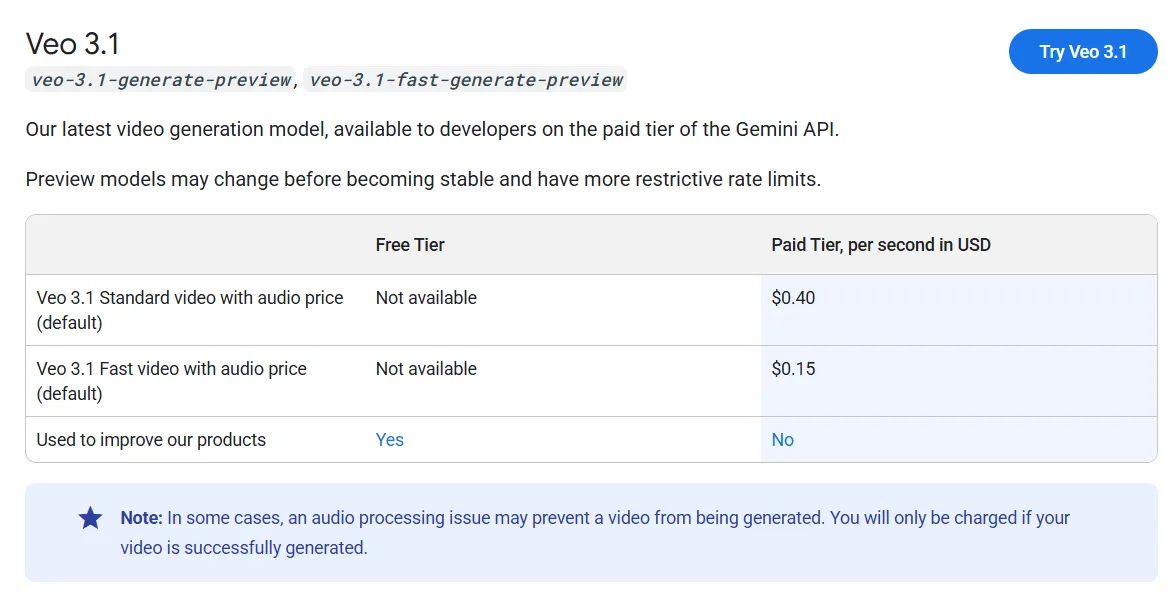

اگر میخواهید امتحانش کنید، بهتر است جیبهای عمیقی داشته باشید. Veo 3.1 در حال حاضر گرانترین مدل تولید ویدئو است، در سطح Sora 2 و فقط پشت سر Sora 2 Pro که بیش از دو برابر هزینه تولید دارد.

کاربران رایگان ۱۰۰ اعتباری ماهانه برای تست سیستم دریافت میکنند که برای تولید حدود پنج ویدیو در ماه کافی است. از طریق API جمینی، هزینه Veo 3.1 تقریباً $0.40 در هر ثانیه ویدئوی تولید شده با صدا، در حالی که یک نسخه سریعتر به نام Veo 3.1 Fast هزینهاش ۰.۱۵ دلار به ازای هر ثانیه است.

برای کسانی که مایلند با آن قیمت از آن استفاده کنند، اینجا نقاط قوت و ضعف آن آورده شده است.

متن به ویدیو

Veo 3.1 بهطوری واضحی نسبت به نسخه قبلی خود بهبود یافته است. این مدل به خوبی انسجام را مدیریت میکند و درک بهتری از محیطهای متنی نشان میدهد.

این در سبکهای مختلف کار میکند، از فتوواقعگرایی تا محتویات سبکدار.

از مدل خواستیم که صحنه را ترکیب کنید که به عنوان یک طراحی شروع شد و به فیلمبرداری زنده منتقل شد. این کار را بهتر از هر مدل دیگری که آزمایش کردیم، انجام داد.

بدون هیچ قاب مرجع، Veo 3.1 در حالت متن به ویدیو نتایج بهتری نسبت به زمانی که از همان درخواست با یک تصویر اولیه استفاده شد، تولید کرد که شگفتانگیز بود.

تجارت این است که سرعت حرکت را قربانی کنید. ویو ۳.۱ بر همخوانی به جای سیالیت اولویت میدهد، که ایجاد اقدامهای سریع را چالشبرانگیز میکند.

عناصر با سرعت کمتری حرکت میکنند اما در طول کلیپ ثبات را حفظ میکنند. کِلینگ هنوز در حرکت سریع پیشتاز است، هرچند که نیاز به تلاشهای بیشتری برای دستیابی به نتایج قابل استفاده دارد.

تصویر به ویدیو

ویو شهرت خود را بر اساس تولید تصویر به ویدیو بنا کرده است و نتایج همچنان ارائه میشوند – با احتیاطهایی. به نظر میرسد این بخش در بروزرسانی ضعیفتر شده است. هنگام استفاده از نسبتهای مختلف بُعد به عنوان فریمهای شروع، مدل در حفظ سطوح همخوانی که قبلاً داشت، دچار مشکل شد.

اگر درخواست بیش از حد از آنچه که به طور منطقی باید پس از تصویر ورودی دنبال شود، منحرف شود، ویو ۳.۱ راهی برای تقلب پیدا میکند. این سیستم صحنهها یا کلیپهای نامربوطی تولید میکند که پرش بین مکانها تنظیمات یا عناصر کاملاً متفاوت.

این زمان و اعتبار را هدر میدهد، زیرا این کلیپها نمیتوانند به توالیهای طولانیتر ویرایش شوند چون با فرمت مطابقت ندارند.

زمانی که کار میکند، نتایج فوقالعاده به نظر میرسند. رسیدن به آن ترکیبی است از مهارت و شانس—بیشتر شانس.

عناصر به ویدیو

این ویژگی مانند ترمیم در ویدیو عمل میکند و به کاربران این امکان را میدهد که عناصری را از یک صحنه وارد یا حذف کنند. با این حال، انتظار نداشته باشید که ثبات کامل را حفظ کند یا تصاویر مرجع دقیقتان را استفاده کند.

به عنوان مثال، ویدیوی زیر با استفاده از این سه مرجع و دستور زیر ایجاد شده است: مردی و زنی در حال دویدن در یک شهر آیندهنگر بر یکدیگر برخورد میکنند، جایی که یک هولوگرام علامت بیتکوین در حال چرخش است. مرد به زن میگوید: “سریع، بیتکوین سقوط کرده! باید بیشتر بخریم!”

به عنوان شما میتوانید ببینید نه شهر و نه شخصیتها واقعاً وجود ندارند. اما شخصیتها لباسهای مرجع را به تن دارند، شهر مشابه شهری است که در تصویر است، و چیزها ایده عناصر را به تصویر میکشند، نه خود عناصر را.

Veo 3.1 عناصر بارگذاری شده را به عنوان منبع الهام در نظر میگیرد تا الگوهای سخت. این نرمافزار صحنههایی را ایجاد میکند که از راهنما پیروی میکنند و شامل اشیائی هستند که شبیه به آنچه ارائه دادهاید میباشند، اما وقت خود را صرف تلاش برای وارد کردن خود به یک فیلم نکنید – این کار نخواهد کرد.

یک راهحل: از Nanobanana یا Seedream برای بارگذاری عناصر و تولید یک فریم شروع منسجم ابتدا استفاده کنید. سپس آن تصویر را به Veo 3.1 بدهید، که ویدیویی تولید میکند که در آن شخصیتها و اشیاء حداقل تغییر شکل را در سراسر صحنه نشان میدهند.

متن به ویدیو با دیالوگ

این نقطه قوت گوگل است. ویو 3.1 بهتر از هر مدل دیگری که در حال حاضر در دسترس است، هماهنگی لب را مدیریت میکند. در حالت تبدیل متن به ویدیو، این مدل تولید میکند. صوت محیطی متجانس که با عناصر صحنه مطابقت دارد.

گفتگو، تن صدا، صداها و احساسات دقیق هستند و از مدلهای رقیب بهتر عمل میکنند.

دیگر ژنراتورها میتوانند نویز محیطی تولید کنند، اما تنها سوره، ویو و گراک قادر به تولید کلمات واقعی هستند.

از آن سه، ویو ۳.۱ به کمترین تلاش برای به دست آوردن نتایج خوب در حالت متن به ویدیو نیاز دارد.

تصویر به ویدیو با دیالوگ

این جایی است که اوضاع خراب میشود. تبدیل تصویر به ویدیو با دیالوگ از همان مشکلات تبدیل تصویر به ویدیو استاندارد رنج میبرد. ویو ۳.۱ تا حدی بر انسجام تمرکز کرده است که به رعایت پرامپت و تصاویر مرجع بیتوجهی میکند.

به عنوان مثال، این صحنه این متن با استفاده از مرجع نمایش داده شده در بخش ویدئو ایجاد شده است.

همانطور که میبینید، تست ما موضوعی کاملاً متفاوت از تصویر مرجع تولید کرد. کیفیت ویدیو عالی بود—خطintonation و حرکات کاملاً درست بودند—اما این فردی نبود که ما بارگذاری کردیم و این نتیجه را بیفایده میکند.

ویژگی ریمیکس سورا بهترین گزینه برای این مورد استفاده است. ممکن است مدل سانسور شده باشد، اما قابلیتهای آن در تبدیل تصویر به ویدیو، همزمانی واقعگرایانه لبها و تمرکز بر لحن، لهجه، احساس و واقعگرایی آن را به برنده واضح تبدیل میکند.

ژنراتور ویدیوی گراک در جایگاه دوم قرار دارد. این ابزار بهتر از ویدیو ۳.۱ و تصویر مرجع را رعایت کرد و نتایج بهتری تولید کرد. اینجا یک نسل است با استفاده از همان تصویر مرجع و درخواست.

اگر نمیخواهید با اپلیکیشن اجتماعی سارا سر و کار داشته باشید یا به آن دسترسی ندارید، گراک ممکن است گزینهی بهتری باشد. این اپلیکیشن همچنین بدون سانسور اما با مدیریت است، بنابراین اگر به این رویکرد خاص نیاز دارید، ماسک به شما کمک کرده است.

عمومی باهوش خبرنامه

یک سفر هفتگی در دنیای هوش مصنوعی که توسط جن، یک مدل هوش مصنوعی تولیدی، روایت میشود.